[논문 소개] Adversarial Attacks Against Medical Deep Learning Systems

- 논문 정보

- 논문 제목: Adversarial Attacks Against Medical Deep Learning Systems

- 논문 링크: https://arxiv.org/abs/1804.05296

오늘 소개시켜드릴 논문은 Adversarial Attacks Against Medical Deep Learning Systems (https://arxiv.org/abs/1804.05296)이란 논문입니다. Harvard Medical School에서 쓰인 논문이지만 그닥 어려운 내용없고 쫄거 없는 내용입니다. 한마디로 하자면 "deep learning으로 만든 medical image 진단 시스템에 adversarial attack을 해 봤다!!" .. 이게 끝..

기술적으로 보자면 Adversarial attack에 대해 더 잘 정리된 논문을 소개시켜드리는게 좋고, 그런 논문은 차라리 최근 Adversarial attack를 하고 정리한 "Adversarial Attacks and Defences Competition (https://arxiv.org/pdf/1804.00097.pdf)"을 보시는게 더 좋고 저도 그 논문을 보고 공부하는 편이 더 좋다고 생각합니다.

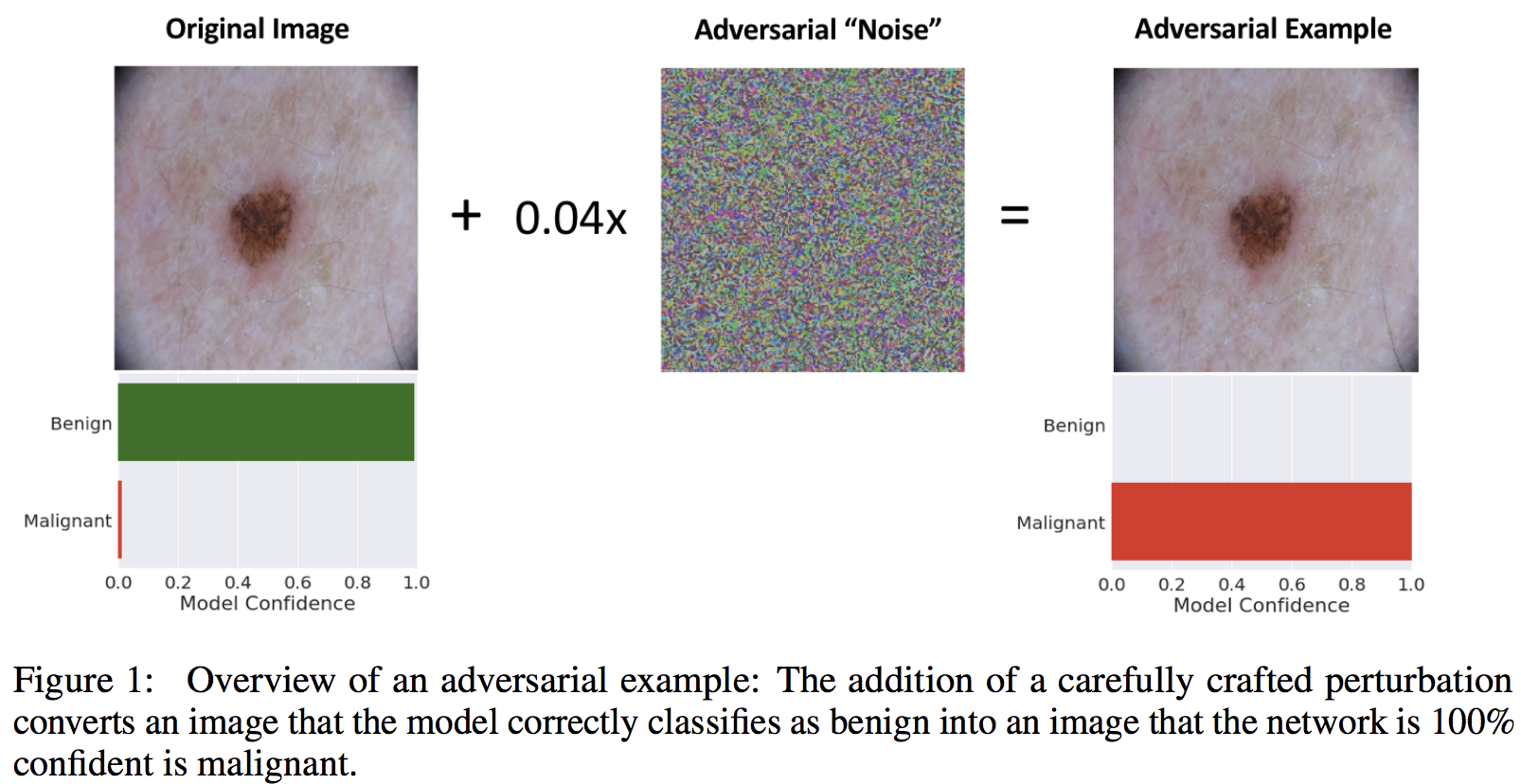

이 논문에서 한 일은 아래 그림과 같습니다.

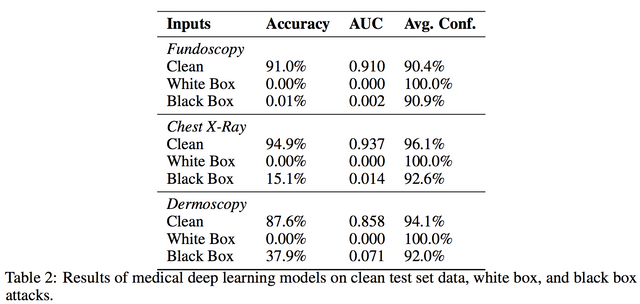

그러니깐.. adversarial example을 만들어서 실험..!! 끝 결과는 아래와 같습니다. 결과도 예상하는 바와 다르지 않다.. 입니다.

그럼에도 이 논문을 읽은 이유는 Medical School에서 쓴 논문이라 그런지 아닌지 모르지만, 기술적으로는 하나도 힘들지 않은 일을 했지만 분석은 기술에서 약간 벗어난 분석도 하고 있어서 입니다. 뭐 엔지니어들이라면 수학적으로 이게 맞네 공격을 더 했네 어떤 방법으로 하니 다 뚫렸네 하고 있겠지만..

Distinctive sources of vulnerability to medical adversarial attacks among medical deep learning systems 섹션을 읽어보시면 왜 medical 데이터에서 이런 공격에 대해 더 취약할 수 있는지 고민하고, 뒷 섹션들을 통해 그런 이슈에 대해 토론을 제시하고 있습니다. 의료 산업면에서 이런 면이 중요하지만, 기술적으로 해결이 다 되지 않는 이유에 대해서도 고민한 흔적이 약간 (정말이지만 약간) 있습니다. 이 부분이 더 중요하다고 생각해서 소개합니다. 뭐.. 이런 공격 어따써 .. 이러다가 자동화된 보험회사 속이는데도 쓸 수 있고.. 이러면서 읽었습니다.

도메인에 있는 분들이 이런 간단한 실험을 통해 이런 이슈를 많이 제시해 주시면 좋을거 같습니다. 실험은 남의 알고리즘 가져다가 잘 수행했지 새로운 알고리즘을 만든게 아니기에 코딩이나 그런게 많이 들지 않는다고 생각합니다. 그러나 그런 간단한 실험을 통해 문제를 제기하고 그 문제에 대해 환기하는게 좋았습니다.

Congratulations @jiwoopapa! You have completed some achievement on Steemit and have been rewarded with new badge(s) :

Click on any badge to view your own Board of Honor on SteemitBoard.

To support your work, I also upvoted your post!

For more information about SteemitBoard, click here

If you no longer want to receive notifications, reply to this comment with the word

STOP