Trzy prawa robotyki. Wymysł pisarza, czy trafny wywód wizjonera?

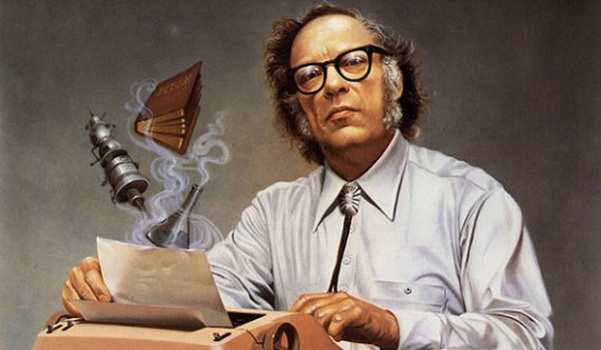

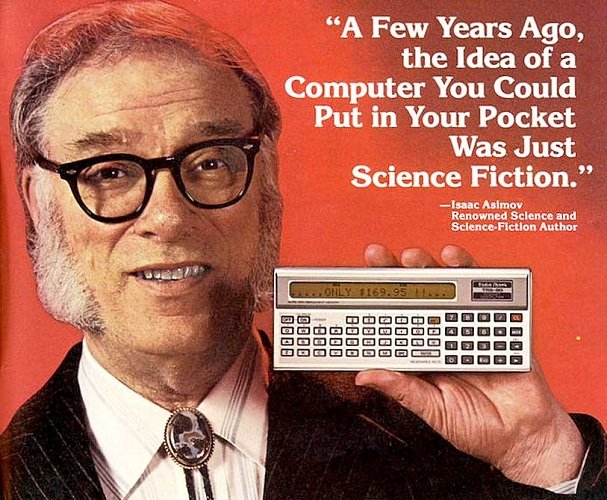

Amerykański pisarz rosyjskiego pochodzenia, Isaac Asimov, w 1942 opracował swoje trzy zasady robotyki. Od tego czasu te trzy prawa są wymieniane jako szablon postępowania z robotami. Wysoko rozwinięta dziedzina robotyki to nic innego jak zaawansowane i rozbudowane linie produkcyjne. Jednak prawa te mają większe zastosowanie przy tworzeniu sztucznej inteligencji. Prace w tej dziedzinie posuwają się w zaskakującym tempie i wydaje mi się, że szybko doprowadzą do momentu, w którym interakcje między robotem a człowiekiem znacznie wzrosną.

Pierwsze trzy prawa:

- Robot nie może skrzywdzić człowieka, ani przez zaniechanie działania dopuścić, aby człowiek doznał krzywdy.

- Robot musi być posłuszny rozkazom człowieka, chyba że stoją one w sprzeczności z Pierwszym Prawem.

- Robot musi chronić samego siebie, o ile tylko nie stoi to w sprzeczności z Pierwszym lub Drugim Prawem.

Po pewnym czasie zostało dodane jeszcze jedno prawo zerowe, które mówi, że:

- Robot nie może skrzywdzić ludzkości, lub poprzez zaniechanie działania doprowadzić do uszczerbku dla ludzkości.

Gdy mamy do czynienia z prostym robotem, który tylko wykonuje proste, z góry ustalone zadanie i nie wchodzi w bliższą relację z człowiekiem, sprawa wydaje się prosta. Mamy odkurzacz, który sam sprząta i podejmuje decyzje w który kąt podjechać, ciężko doszukiwać się tu łamania wyżej wymienionych praw. Taki odkurzacz jest w 100% posłuszny człowiekowi, nie krzywdzi go i rzetelnie wykonuje swoją pracę.

Problematycznym jednak staje się użycie robotów w branży militarnej. Można stwierdzić, że urządzenia przeznaczone do szpiegowania, usuwania bomb czy celów transportowych będą działały w zgodzie z prawami Asimova. Jeśli jednak umieścimy robota na polu bitwy to pierwsze prawo, mówiące o tym, że nie może szkodzić ludziom, jest niespełniane. Gdyby jedyną rolą wojska było ratowanie życia żołnierzy i cywili, byłoby to w zgodzie w wyżej wymienionymi prawami. Jednak kluczową rolę w wojsku odgrywa niszczenie wrogów na polu bitwy a to zdecydowanie jest sprzeczne z założeniami tych praw.

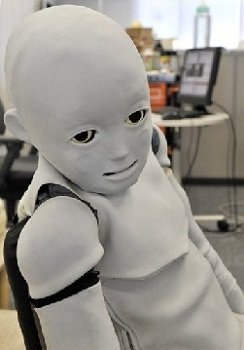

Niejednoznaczność sformuowania powoduje, że prawa mogą być błędnie zinterpretowane czy niewłaściwie zastosowane. Jednym z problemów jest to, że nie określają dokładnie czym jest robot. W miarę jak odkrycia i innowacje techniczne przesuwają granice technologii, pojawiają się nowe dziedziny robotyki. Pojawia się również pytanie, co powinniśmy uznawać za szkodliwe dla człowieka. Czy wyrządzenie szkody fizycznej może być równomierne ze szkodą psychiczną czy emocjonalną? Czy adoptowanie dzieci-robotów czy przywiązywanie się i zaprzyjaźnianie z inteligentnymi androidami może taką szkodę wyrządzić?

Inną ważną kwestią związaną z tymi prawami jest to, że potrzebujemy znacznego postępu w zakresie sztucznej inteligencji, aby roboty mogły rzeczywiście ich przestrzegać. Cel badań nad sztuczną inteligencją jest przedstawiany jako rozwój maszyn, które potrafią myśleć i działać racjonalnie jak człowiek. Jak dotąd, naśladowanie ludzkich zachowań nie zostało dokładnie zbadane w dziedzinie sztucznej inteligencji.

Podstawową kwestią, której Asimov nie wziął pod uwagę podczas konstruowania praw to możliwość współistnienia i koegzystencji na zasadzie wzajemnego poszanowania. Prowadzi to do sytuacji, w której podporządkowani zostają ci, których prawa obowiązują tym, którzy te prawa stworzyli. Konsekwencją takiej władzy nad sztuczną inteligencją może być konflikt stron człowiek-robot, bunt i w ostateczności podjęcie się działań ekstremalnych. Stąd wniosek, że te prawa powinny mieć zastosowanie tylko w przypadku maszyn o niskiej autonomii.

Niemniej jednak prawa robotyki przyświecają wielu inżynierom, konstruktorom czy programistom, którzy zajmują się pracą w dziedzinie sztucznej inteligencji i robotyki. Trzeba przyznać, że Isaac Asimov okazał się niezykłym wizjonerem, który przewidział zaawansowany rozwój techniki ponad siedemdziesiąt lat temu.

Dobrze zrobiony post, jesli można, dołożę trochę kontekstu AD 2018 :)

Najciekawszym novum, związanym z prawami Asimova i w ogóle współżyciem ludzi i zaawansowanych technologicznie maszyn - jest moim zdaniem pytanie o maszyny wyposażone w inteligencję przewyższającą naszą własną. Już trwa debata o samouczących się SI, rozwiązujących problemy przy użyciu metod dla nas niezrozumiałych lub nie kontrolowanych (czarne skrzynki). Czy nie stwarzamy nowego gracza w ewolucję, czyli grę, w którą możemy z nim przegrać? Czy nie powinniśmy powoli zacząć myśleć o prawach dla dobra... robotów, analogicznych do "praw człowieka"?

Za czasów Asimova, ba, jeszcze 10 lat temu, przed deep learnig - takie problemy były jeszcze nie do pomyślenia...

I have a flare for robots. Good presentation @shiningowl

Thank you, I will post the duplicate in english soon.

OK friend.

Teraz są te super inteligentne samochody. A jeśli komputer pokładowy wykryje że kolizja jest nieunikniona? I będzie miał do wyboru albo przejechać staruszkę albo małe dziecko?

Tu się właśnie pojawia dylemat. Algorytm takiego samochodu 'myśli' dużo kroków w przód i zauważa rzeczy i anomalia, przewidując przy tym różne scenariusze, których ludzkie oko by nie dostrzegło. Dlatego mam nadzieję, że takie auto nie będzie musiało stawać przed takim wyborem.

Robotyka raczej, nie ma z tym problemu. To jedynie problem sztucznej inteligencji i programistów. Podczas konstruowania robotów, dobiera się priorytety w postaci czynności, do których robot jest przeznaczony, a następnie wszystkie czujniki i elementy napędowe. Układ sterujący, ma za zadanie przetworzyć otrzymane sygnały i dostosować ruchy robota do zaprogramowanego działania. Z ekonomicznego punktu widzenia, jest to mało prawdopodobne, by ktoś poświęcał czas i środki na stworzenie "robociej" świadomości istnienia :D